Profesionales

USO DE IA EN SALUD

¿Se puede confiar 100% en los diagnósticos con inteligencia artificial?

La OMS habla sobre la responsabilidad final de los profesionales de la salud

Martes, 06 de junio de 2023, a las 11:58

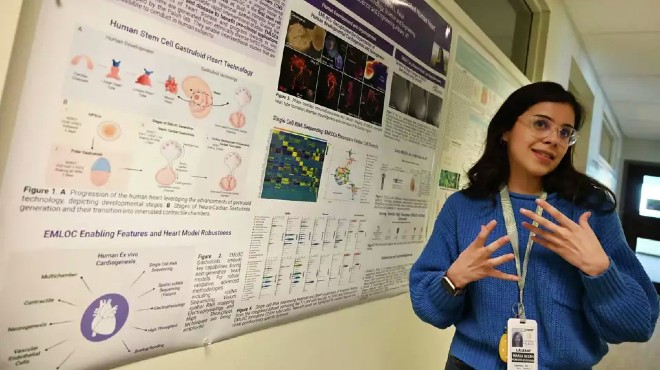

Estas tecnologías siempre deben ser controladas o supervisadas por seres humanos. |

Redacción. Quito

Las herramientas de inteligencia artificial no son infalibles y, en el caso de la sanidad, su nivel de eficiencia depende de que se hayan elaborado según una serie de parámetros científicos y éticos. Por ello, solo deben usarse herramientas basadas en algoritmos transparentes o conocidos, ha advertido la Organización Mundial de la Salud (OMS).

La inteligencia artificial se ha convertido en una herramienta muy útil que ya ha alcanzado la salud y que indudablemente la Medicina se ha beneficiado de las tecnologías digitales, pero al igual que en todos los campos, las ventajas que ofrecen también conllevan riesgos que se deben atajar.

En repetidas ocasiones la OMS ha advertido que el uso inadecuado de la inteligencia artificial puede perjudicar a los pacientes con diagnósticos erróneos o tratamientos equivocados, por eso, si bien las herramientas se pueden usar, las decisiones deben estar siempre a cargo de un profesional de la salud capacitado.

Según Marcelo D´Agostino, jefe de Sistemas de Información y Salud Digital de la Organización Panamericana de la Salud (OPS), si bien la inteligencia artificial empezó a usarse en la Medicina hace varias décadas, fue la pandemia de COVID-19 que puso en relevancia la transformación digital.

“Su utilización se remonta a la década de los 60 y 70, cuando empezaron los llamados sistemas expertos o basados en reglas lógicas, pero el principal punto de inflexión fue en 1980, cuando aparecieron los sistemas en los que las computadoras aprenden y automáticamente llevan a cabo análisis a partir de grandes cantidades de datos médicos”. A partir de esos algoritmos con capacidad de aprender, en la década de los 90 comenzó propiamente el uso de la inteligencia artificial en la interpretación de imágenes, según Noticias ONU.

“Esto fue un poco inspirado por otras tecnologías como la utilizada por la NASA para la captura de imágenes. En la Medicina se empezaron a utilizar entonces también en la interpretación de imágenes, como radiografías o resonancias magnéticas”.

Posteriormente, la inteligencia se incorporó a la big data, los datos masivos, para analizar los grandes conjuntos de datos que dio lugar a lo que hoy es posible: modelos de predicciones, descubrimientos, e inclusive de fármacos.

La inteligencia artificial también ha impulsado la Medicina de Precisión a partir de herramientas que analizan grandes volúmenes de datos, lo que antes era impensable. Esto sin incluir la detección temprana de enfermedades a partir de datos genéticos.

Y lo último, lo más visible después de la aparición de los chatbots o herramientas para conversar con máquinas: la gran ola de los últimos meses con el ChatGPT y otras herramientas con las que se puede conversar y a las que se puede pedir información, ha indicado D´Agostino.

¿Se pueden hacer diagnósticos con la inteligencia artificial?

D´Agostino ha sostenido que sí, pero ha sido enfático en aclarar que estas tecnologías siempre deben ser controladas o supervisadas por seres humanos, es decir, “no dejar que la herramienta haga el diagnóstico y confiar un 100 por ciento en ese diagnóstico porque también se han identificado algunas fallas”.

“Siempre tiene que estar acompañado de profesionales, siempre debe tener una serie de parámetros para que uno pueda utilizarlo como instrumento de apoyo… La idea es que un profesional, en última instancia, sea quien tenga la responsabilidad de diagnosticar, de tomar decisiones”, ha insistido.

Asimismo, ha señalado que el control de las personas también es fundamental para la robótica quirúrgica, las cirugías asistidas por robots que buscan mayor precisión en los movimientos, así como intervenciones menos invasivas.

En cuanto al uso de ChatGPT, que puede procesar grandes volúmenes de información y proponer un resumen en cuestión de segundos, ha considerado que es muy importante que haya profesionales, trabajadores de la salud que sepan cómo se deben utilizar estas herramientas.

Por este motivo, ha recomendado no tener demasiada confianza en estas herramientas y tampoco dejar de estudiar y actualizarse por cuenta propia.

“Hoy estamos en un momento de convergencia donde hay mucho profesional y trabajador que utiliza herramientas de inteligencia artificial o que tiene acceso a estas herramientas, pero que no tuvo contacto con nada de la salud digital a lo largo de su formación profesional”, ha explicado.

A su criterio, con el paso del tiempo las nuevas generaciones se formarán con estas herramientas, que será parte de su proceso educativo. No obstante, “en este momento hay mayor riesgo… No necesariamente la gente tiene hoy esa capacidad de discernir entre una herramienta que puede utilizar fuentes basadas en evidencia o una herramienta que no tiene ningún tipo de sustento de evidencia científica y que no se sabe de dónde está sacando la información”.

Por esta misma razón, la OPS ha destacado la importancia de utilizar herramientas basadas en algoritmos transparentes o conocidos, de no ser así, “no se sabe lo que hay por detrás de una herramienta o software basado en inteligencia artificial. Si uno no conoce lo que hay por detrás, el riesgo es aún mayor”.

En este sentido, D´Agostino ha reiterado en que un profesional de la salud “tiene que asumir siempre la responsabilidad final de cualquier decisión clínica”.

En el mundo digital tomará tiempo formar una cultura en la que se entienda cómo se produjeron las herramientas tecnológicas, cuáles son sus fuentes, quién está detrás, qué tan seguras son.

Por ello, dado la diversidad de fuentes, la OMS y la Unión Internacional de Telecomunicaciones (UIT) están trabajando en conjunto en la definición de todos los estándares, “del concepto de la importancia del uso de algoritmos abiertos y de acercar a las cada vez más numerosas las agencias reguladoras y comisiones de parlamentarios de los países para que puedan modificar las legislaciones, los instrumentos normativos en base a todos estos principios técnicos”.

Sin embargo, el riesgo de un mal uso de la inteligencia artificial no es solo para los trabajadores sanitarios sino se extiende a los usuarios de internet en general, que pueden hacer cualquier consulta de salud a distintos chatbots y plataformas, sin saber si la respuesta que obtendrán tiene un sustento científico ni si es adecuada para ellos.

Al respecto, D´Agostino ha indicado que los expertos en el tema han discutido mucho ese punto y saben que se trata de un fenómeno que sobrepasa a la OMS y a cualquier otra agencia, por lo que la respuesta debe encontrarse en una alianza sólida entre el sector salud y el sector educación.

“Eso es incontrolable porque es como querer controlar la web, ya es algo que está por encima de todo y que en muchos casos tiene vida propia. Lo que pensamos que podría llegar a ser un muy buen elemento de contención es la educación desde la escuela primaria… Uno de los elementos de contingencia que puede ser muy efectivo es incorporar los temas de transformación digital a lo largo de la formación de una persona en toda su vida”, ha enfatizado.

El problema radica en que el uso de las herramientas digitales se aprende cuando una persona termina la formación universitaria e incluso certificaciones de maestría o doctorado que hoy todavía no incluyen estos elementos en todas sus dimensiones.

“La formación continua a lo largo de toda la vida de una persona podría ser un elemento de contención importante, no la solución, porque va a ser muy difícil controlar todo lo que pase en la web y en el mundo del desarrollo tecnológico. Pero si creamos esta cultura e impulsamos la educación, se puede minimizar muchísimo cualquier impacto negativo”, ha recalcado.

Le puede interesar: La adopción precipitada de la inteligencia artificial en Salud puede causar daños a los pacientes